在高性能计算(HPC)领域,网络线缆的性能和稳定性至关重要。HPC用户对网络要求极高,往往倾向于选择原厂线缆,而对第三方线缆有所顾虑。以下将深入探讨HPC用户拒绝第三方线缆的原因,并对Mellanox稳定性进行实证分析。

一、为什么HPC用户拒绝第三方线缆

性能一致性难以保证:HPC系统对数据传输的稳定性和速度要求极为苛刻。第三方线缆在带宽、延迟等关键性能指标上可能无法与HPC系统的整体要求精确匹配。例如,在大规模并行计算中,若第三方线缆无法提供稳定的高带宽,可能导致数据传输瓶颈,影响计算任务的进度。

兼容性风险较高:HPC系统通常由多种复杂的硬件和软件组件构成。第三方线缆可能与系统中的其他设备,如Mellanox网卡、交换机等存在兼容性问题。这种不兼容可能引发系统故障,如数据丢包、通信中断等,严重影响HPC系统的正常运行。

质量和可靠性存疑:第三方线缆的生产工艺和质量控制水平参差不齐。一些第三方线缆可能采用劣质材料,在长期高负荷运行下,容易出现线缆老化、损坏等问题,影响HPC系统的可靠性和稳定性。而且,第三方线缆的售后服务和技术支持相对薄弱,一旦出现问题,难以快速有效地解决。

二、Mellanox稳定性实证之硬件设计与技术

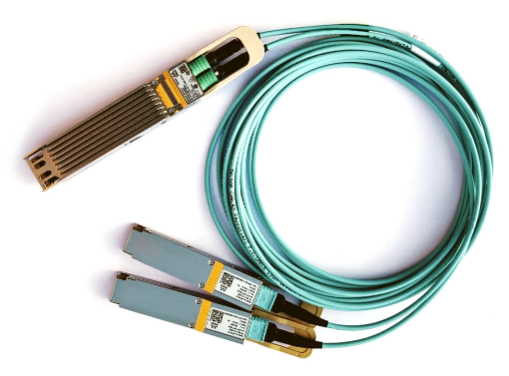

先进的物理层技术:Mellanox线缆采用了先进的信号传输技术,如PAM4编码等,能够在高速传输下保持信号的完整性。以Mellanox的400G InfiniBand线缆为例,利用100Gb/s的PAM4 Serdes技术,实现了400Gb/s的单端口传输带宽,且信号衰减极低。

强大的硬件加速引擎:Mellanox网卡和线缆配合,具备多种硬件加速引擎。如NDR InfiniBand实现了对于业界最头疼的All2All和Allreduce通信的硬件卸载,能让MPI通信的性能提升四倍,大大提高了数据传输效率和稳定性。

拓扑结构优势:Mellanox的DragonFly+网络拓扑可以在4个交换机Hop内达到一百万个节点的同时通信,这个规模远远超出了E级机、甚至10E级机或百E级机需要的规模,为大规模HPC集群提供了稳定的网络基础。

三、Mellanox稳定性实证之实际应用案例

BP英国石油案例:BP曾采购1000节点的集群,其中700台为Mellanox InfiniBand网络,300台为英特尔Omni - Path网络。经过1年的试用,BP发现Mellanox网络的系统性能是Omni - Path的2.5倍。在完成同样任务的情况下,采用Mellanox InfiniBand整套系统部署的成本更低,这充分证明了Mellanox在实际HPC应用中的稳定性和性能优势。

超算中心应用:全球许多超算中心都采用了mellanox线缆和网络解决方案。例如,某知名超算中心使用Mellanox的400G InfiniBand产品构建其网络架构,在长期运行中,实现了高并发、大规模数据的稳定传输,为科研人员提供了强大的计算支持,其系统的可靠性和稳定性得到了充分验证。