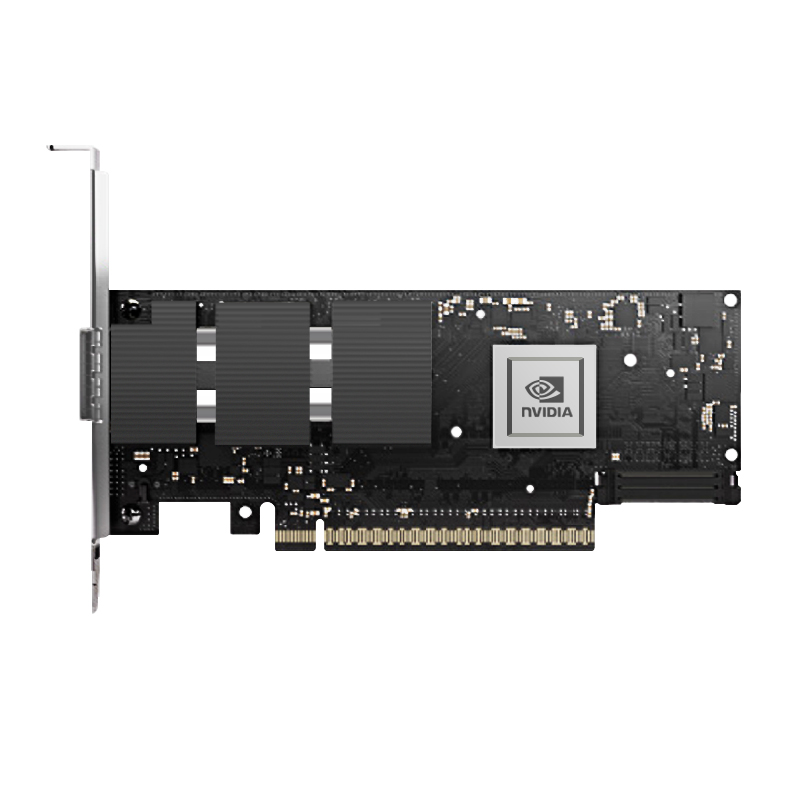

作为HPC和AI训练网络的核心组件,Mellanox 200G InfiniBand网卡在超算领域占据主导地位。2023年TOP500数据显示,采用HDR 200G方案的超算系统占比达61%。本文将全面解析这款高性能网卡的技术特性与应用实践。

一、产品核心规格

| 型号 | MCX653105A-ECAT | MCX653106A-ECAT | MCX653107A-ECAT |

|---|---|---|---|

| 端口配置 | 单端口HDR | 双端口HDR | 双端口HDR+PCIe 4.0 |

| 理论带宽 | 200Gbps | 2×200Gbps | 2×200Gbps |

| 协议支持 | IB/RoCEv2/MPI | IB/RoCEv2/MPI | IB/RoCEv2/MPI/SHARP |

| 典型延迟 | 0.6μs | 0.7μs | 0.5μs |

| 功耗 | 18W | 25W | 28W |

| 市场价格 | ¥9,800-14,500 | ¥15,000-22,000 | ¥18,000-26,000 |

注:MCX653107A支持SHARPv2聚合计算,可提升集体通信效率5倍。

二、关键技术特性

1. 网络加速技术

GPUDirect RDMA:实现GPU显存直接访问

# 启用GPUDirect export NCCL_IB_HCA=mlx5 export NCCL_NET_GDR_LEVEL=5

SHARPv2:支持计算网络聚合,减少AllReduce操作时间

2. 高级虚拟化支持

SR-IOV虚拟化(单卡256 VFs)

# 配置虚拟功能 echo "32" > /sys/class/net/ib0/device/sriov_numvfs

硬件级QoS(8个流量类别)

三、典型应用场景

1. 超算中心部署

配置方案:

每计算节点配置2块MCX653106A

采用Dragonfly+拓扑

性能指标:

• 节点间延迟:1.2μs • MPI_Allreduce:3.5μs(256节点) • 可持续带宽:193Gbps/端口

2. AI训练集群

| 组件 | 连接方案 | 性能参数 |

|---|---|---|

| DGX A100 | 8×HDR 200G | 1.6Tbps双向带宽 |

| 存储节点 | 4×HDR 200G | 76GB/s吞吐 |

四、性能调优指南

1. 延迟优化配置

调整中断合并参数:

echo "50" > /sys/class/InfiniBand/mlx5_0/ports/1/cma/interrupt_moderation

启用低延迟模式:

mlxconfig -d /dev/mst/mt4123 set FORWARDING_MODE=0

2. 吞吐优化方案

配置Jumbo Frame:

ifconfig ib0 mtu 4096

优化MPI参数:

export MPI_IB_RA=1 export MPI_IB_CONGESTION_CONTROL=1

五、运维监控实践

| 监控项 | 检测命令 | 健康阈值 |

|---|---|---|

| 端口状态 | ibstat | grep State | Active |

| 误码统计 | ibqueryerrors -d mlx5_0 | ≤1E-12 |

| 温度监控 | ibv_devinfo -v | grep temp | ≤85℃ |

六、选型与部署建议

选型决策树:

基础HPC:MCX653105A(单端口)

AI训练:MCX653106A(双端口)

超算中心:MCX653107A(支持SHARP)

部署注意事项:

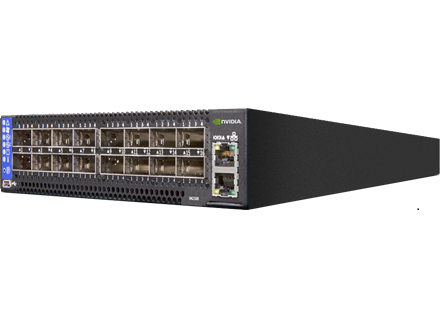

确保交换机支持HDR 200G(如Quantum-2系列)

推荐使用Mellanox原厂线缆(如MCP7H00-G030)

固件版本需≥20.35.2002

每月执行ibdiagnet全网诊断

典型性能数据:

200节点集群中,SHARPv2使AllReduce性能提升4.8倍

GPUDirect RDMA延迟低至0.8μs

能效比达95Gbps/W