随着AI算力需求的爆发式增长,高频高速数据线材作为服务器互联的关键组件,其性能直接影响整体计算效率。2025年全球AI服务器用高速线材市场规模预计突破80亿美元,带宽需求正从200G向400G快速演进。

一、核心产品技术参数对比

| 线材类型 | 带宽能力 | 典型时延 | 传输距离 | 2025主流型号 |

|---|---|---|---|---|

| NVLink 4.0 | 900GB/s | 50ns | ≤3m | NVIDIA SX8000 |

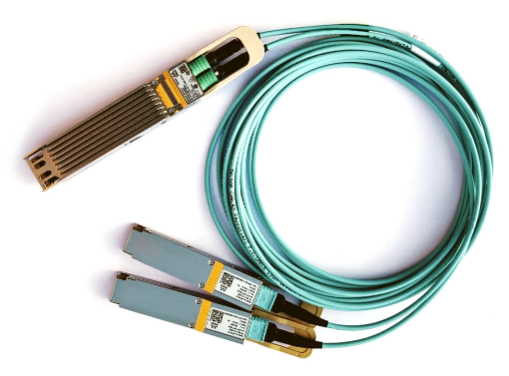

| InfiniBand NDR | 400Gb/s | 70ns | 100m | Mellanox MQM8700 |

| PCIe 5.0铜缆 | 128GT/s | 100ns | ≤5m | Amphenol TCS系列 |

| 硅光引擎线缆 | 1.6Tb/s | 85ns | 50m | Intel co-packaged |

二、关键技术特性

超低损耗材料:采用PTFE/氟聚合物介质,56Gbps下损耗≤0.5dB/inch

抗干扰设计:多层屏蔽结构,串扰抑制优于-50dB@28GHz

热管理优化:石墨烯导热层使工作温度降低15-20℃

连接器创新:高频MPO-24接口支持≥5000次插拔

三、AI集群典型配置方案

GPU间互联:

8卡HGX系统推荐NVLink 4.0线材,全互联带宽7.2TB/s

节点间通信:

采用400G NDR光缆,1:1非阻塞拓扑

存储网络:

200G HDR分支线缆,支持GPUDirect Storage

四、选型关键指标

56G/112G PAM4眼图余量≥15%

插入损耗≤3dB/10GHz

工作温度范围-40℃~85℃

支持热插拔和误码率监测

2025年主流AI服务器厂商已全面转向400G互联架构。建议新建项目选择同时支持NRZ和PAM4调制的线材,并确保与交换设备的光电协同设计。对于超过1000节点的超大规模集群,建议采用co-packaged硅光方案以降低30%功耗。采购时应要求供应商提供完整的TDR测试报告和32G/64G信道参数分析。