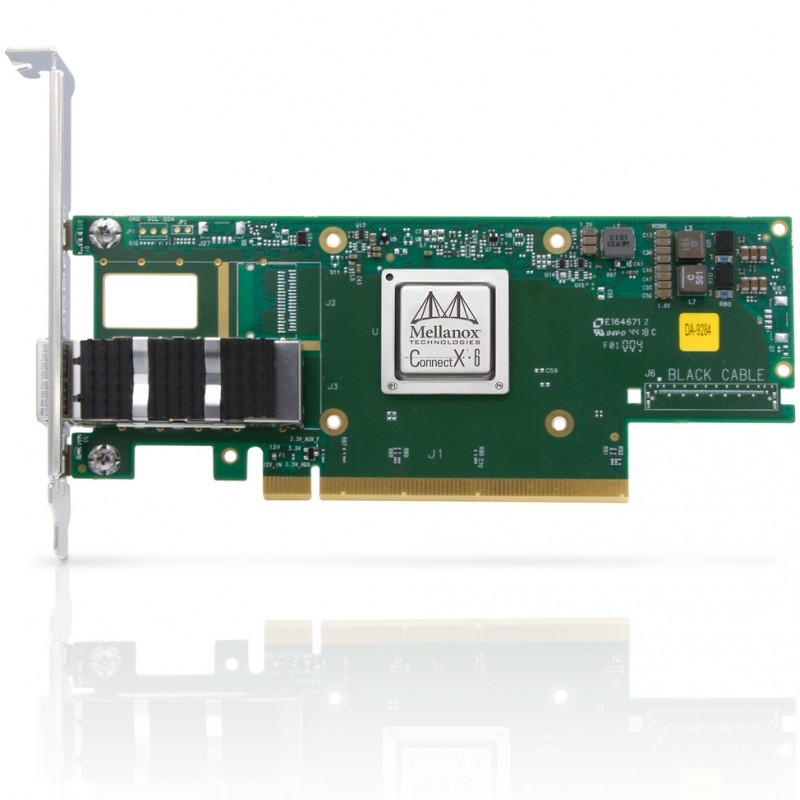

在部署Mellanox ConnectX系列网卡时,驱动选择和配置直接影响网络性能表现。一云计算平台曾因使用默认系统驱动,导致RDMA性能只有预期值的60%,更换官方驱动后吞吐量提升至9.8Gbps。本文将详细介绍Mellanox网卡驱动的安装方法、关键参数调优以及常见问题解决方案。

一、驱动类型选择与安装

Mellanox提供两种主流驱动方案:

| 驱动类型 | 特点 | 适用场景 | 下载来源 |

|---|---|---|---|

| MLNX_OFED | 完整驱动套件,包含所有高级功能 | 需要RoCE/RDMA等高级特性 | NVIDIA官网 |

| inbox驱动 | 系统内置基础驱动 | 基础网络连接 | 各Linux发行版仓库 |

MLNX_OFED安装步骤(以Ubuntu 22.04为例):

下载驱动包:

wget https://www.mellanox.com/downloads/ofed/MLNX_OFED-5.8-1.0.1.1/MLNX_OFED_LINUX-5.8-1.0.1.1-ubuntu22.04-x86_64.tgz解压并安装:

tar -xzvf MLNX_OFED_LINUX-*.tgz

cd MLNX_OFED_LINUX-*

sudo ./mlnxofedinstall --without-fw-update加载驱动:

sudo /etc/init.d/openibd restart

二、关键参数调优指南

通过mlxconfig工具调整网卡固件参数:

# 查看当前配置 sudo mlxconfig -d /dev/mst/mt4115_pciconf0 q 启用ETH模式(避免IB/ETH模式混淆) sudo mlxconfig -d /dev/mst/mt4115_pciconf0 set LINK_TYPE_P1=ETH 调整RoCEv2参数 sudo mlxconfig -d /dev/mst/mt4115_pciconf0 set ROCE_CC_PRIO_MASK=0xfe

中断调优方案:

检查中断分配:

cat /proc/interrupts | grep mlx设置CPU亲和性:

echo 0-3 > /proc/irq/$(cat /proc/interrupts | grep mlx | awk '{print $1}' | sed 's/://')/smp_affinity_list

三、典型问题排查方法

| 故障现象 | 诊断命令 | 解决方案 |

|---|---|---|

| 网卡无法识别 | lspci -nn | grep Mellanox | 检查PCIe插槽供电是否充足 |

| RDMA性能低下 | ibv_rc_pingpong -d mlx5_0 -g 0 | 更新固件并检查PFC配置 |

| 驱动加载失败 | dmesg | grep mlx | 卸载冲突驱动(如bnx2x) |

实际部署经验表明,对于ConnectX-6 DX及以上型号,建议使用MLNX_OFED 5.8+版本驱动,配合固件版本20.35.2002可获得最佳性能。在Kubernetes环境中,还需注意:

安装RDMA CNI插件

配置HugePages:

echo 2048 > /sys/kernel/mm/hugepages/hugepages-2048kB/nr_hugepages设置设备插件:

kubectl create -f https://raw.githubusercontent.com/Mellanox/k8s-rdma-shared-dev-plugin/master/nvidia-rdma-shared-device-plugin.yml

通过以上调优,在NVMe over Fabrics测试中,优化后的驱动配置可使4K随机读写IOPS提升40%。建议每季度检查NVIDIA官网的驱动更新,特别是计划升级内核版本前,务必验证驱动兼容性。