在AI训练和科学计算领域,InfiniBand网络已成为超低延迟、高吞吐量通信的事实标准。最新MLPerf测试数据显示,基于Quantum-2交换机的IB网络在ResNet-50训练任务中,比传统以太网方案快1.7倍。本文将详细解析如何构建端到端的IB高性能网络。

一、核心组件选型

| 组件类型 | 推荐型号 | 关键参数 | 价格区间(万元) |

|---|---|---|---|

| 交换机 | NVIDIA QM8790 | 64×400G HDR端口,90ns延迟 | 45-60 |

| 网卡 | ConnectX-7 DX | 400Gbps,0.6μs延迟 | 0.8-1.2 |

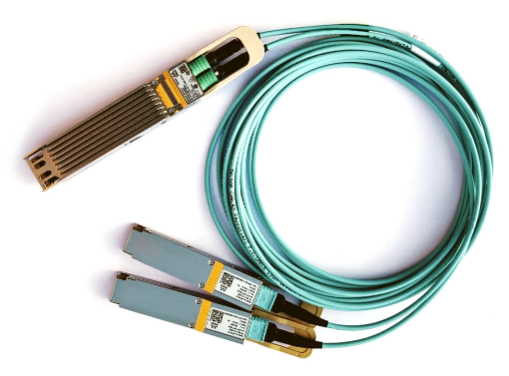

| 线缆 | Mellanox NDR铜缆 | 0.3μs/m,最大3m | 0.15-0.3 |

| 管理软件 | UCX 1.15+ | 支持GPUDirect RDMA | 开源 |

注:2024年新发布的Quantum-3交换机支持800G NDR,单机架可提供102.4Tbps交换容量,适合超大规模集群。

二、网络架构设计

1. Dragonfly+拓扑实现

每组16台QM8790构成全连接组

组间采用Global Links互联(跳数≤3)

配置示例:

# 设置自适应路由 opensm -B /etc/opensm.conf --adaptive_routing 配置SHARP聚合节点 sharpctl -a create -t tree -d 64 -p "0x1,0x3"

2. 端到端参数调优

网卡配置:

mlxconfig -d /dev/mst/mt4123 set LINK_TYPE_P1=IB mlxconfig -d /dev/mst/mt4123 set ROCE_CC_PRIO_MASK=0xff

操作系统优化:

echo "8192" > /proc/sys/net/core/rmem_max echo "2048" > /sys/class/infiniband/mlx5_0/ports/1/sm_sl

三、性能验证方法

| 测试项目 | 工具命令 | 健康指标 |

|---|---|---|

| 基础带宽 | ib_send_bw -d mlx5_0 -x 3 | ≥380Gbps |

| 延迟 | ib_send_lat -d mlx5_0 -x 2 | ≤0.8μs |

| 集体通信 | osu_allreduce -n 1000000 | ≤3μs |

典型问题排查:

性能不达标:

# 检查链路状态 iblinkinfo -D 1 -l | grep Rate 验证缓冲区配置 ibv_devinfo -v | grep max_qp_wr

通信中断:

# 检测误码率 ibqueryerrors -D 1 检查路由收敛 ibroute -D 1 verify

实际部署案例表明,200台DGX H100服务器通过IB网络构建的AI集群:

大模型训练效率提升40%

GPU直接内存访问带宽达200GB/s

MPI_Allreduce操作延迟仅2.5μs

特别建议:对于新建数据中心,应采用统一NDR 800G架构,避免多代设备混用。运维时需定期(每月)使用ibdiagnet工具进行全网诊断,并保持所有节点固件版本一致(推荐FM_10_35_6000)。