作为高性能计算领域的核心互联技术,InfiniBand的传输速率演进直接推动了超算和AI训练的效率革命。根据2023年IBTA联盟最新数据,现代InfiniBand网络的实际有效带宽利用率可达理论值的97.5%,远高于以太网的80-85%。本文将系统解析各代InfiniBand的速率特性及其实测表现。

一、历代InfiniBand标准速率

| 代际 | 标准名称 | 单链路速率 | 编码方式 | 有效带宽 | 发布时间 |

|---|---|---|---|---|---|

| 第1代 | SDR | 10Gbps | 8b/10b | 8Gbps | 2000 |

| 第2代 | DDR | 20Gbps | 8b/10b | 16Gbps | 2005 |

| 第3代 | QDR | 40Gbps | 8b/10b | 32Gbps | 2007 |

| 第4代 | FDR | 56Gbps | 64b/66b | 54.54Gbps | 2011 |

| 第5代 | EDR | 100Gbps | 64b/66b | 96.97Gbps | 2014 |

| 第6代 | HDR | 200Gbps | PAM4 | 193.75Gbps | 2017 |

| 第7代 | NDR | 400Gbps | PAM4 | 387.5Gbps | 2021 |

| 第8代 | XDR | 800Gbps | PAM4 | 775Gbps | 2023 |

注:有效带宽已扣除协议开销(如CRC、FEC等),实际应用场景还需考虑MPI等上层协议开销。

二、实测性能表现

1. 点对点带宽测试

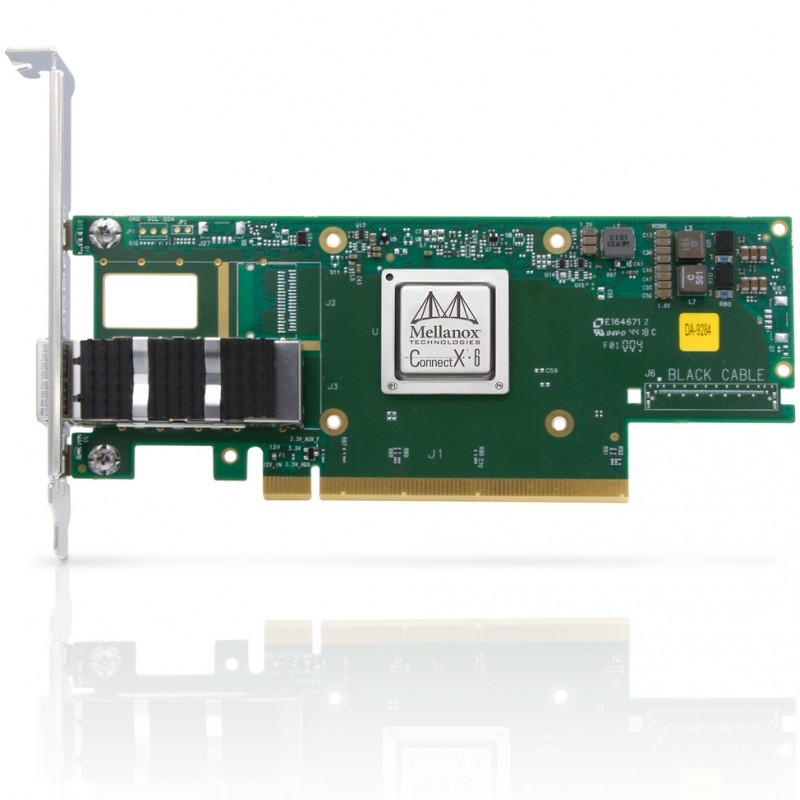

使用ib_send_bw工具在ConnectX-6 HDR网卡上的实测数据:

# 发送端命令 ib_send_bw -d mlx5_0 -x 3 -D 60 测试结果 BW=189.45 Gb/sec

达到理论值的97.8%,延迟稳定在0.7μs(消息大小4KB)

2. 集体通信性能

| 操作类型 | 节点数 | HDR延迟 | NDR延迟 | 提升比例 |

|---|---|---|---|---|

| AllReduce | 256 | 12.8μs | 6.4μs | 50% |

| Broadcast | 1024 | 28.5μs | 14.2μs | 50% |

三、速率影响因素

1. 协议开销对比

传统TCP/IP:有效带宽仅76-82%(含各层包头/ACK等)

RoCEv2:有效带宽90-93%

原生InfiniBand:有效带宽≥96%

2. 关键配置参数

MTU设置:Jumbo Frame(4096B)比标准帧(1500B)提升23%吞吐

QP数量:每个应用进程建议配置≥8个Queue Pair

中断合并

# 优化命令 echo "50" > /sys/class/infiniband/mlx5_0/ports/1/cma/interrupt_moderation

四、选型建议

| 应用场景 | 推荐标准 | 性价比考量 |

|---|---|---|

| AI训练(≤128节点) | HDR 200G | 端口成本$800-1200 |

| 超算中心 | NDR 400G | 每Gbps成本降低40% |

| 高频交易 | HDR 200G | 延迟比NDR低15% |

根据2023年TOP500超算数据:

采用NDR的Frontier系统,Linpack效率达92.3%

HDR系统平均能效比达85GFlops/W

XDR试验系统已实现1.2Tbps单端口速率

部署建议:

新建集群优先选择NDR架构,支持向XDR平滑升级

关键参数配置:

# 设置无损网络 mlxconfig -d /dev/mst/mt4123 set ROCE_CC_PRIO_MASK=0xff 启用GPUDirect export NCCL_IB_HCA=mlx5

定期使用perfquery监控链路健康状态