在数据中心网络升级过程中,万兆以太网卡(10GbE)已成为服务器标准配置。根据IDC最新报告,2025年中国市场万兆网卡出货量预计突破300万片,其中智能网卡占比将达到35%。本文将深入分析万兆网卡的技术特性、性能差异及典型应用方案。

一、万兆网卡核心技术参数

| 技术指标 | 基础型 | 高性能型 | 智能网卡 |

|---|---|---|---|

| 接口类型 | 10G BASE-T | SFP+ | SFP+/OCP |

| 协议支持 | TCP/IP | RDMA RoCEv2 | vSwitch卸载 |

| 延迟 | 15μs | 3μs | 5μs |

| 最大吞吐 | 9.4Gbps | 9.8Gbps | 9.6Gbps |

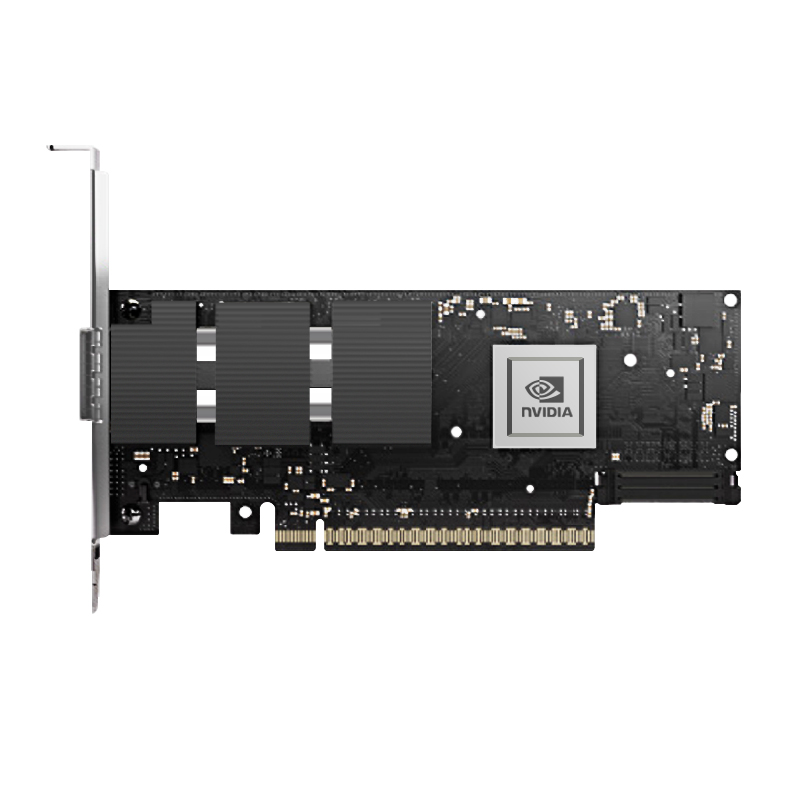

| 典型型号 | Intel X550-T2 | Mellanox CX4121A | NVIDIA ConnectX-6 Lx |

注:2025年新发布的智能网卡已支持SR-IOV虚拟化(≥256 VF)和TLS 1.3硬件加速,价格区间为2500-6000元人民币。

二、典型应用场景配置

1. 虚拟化平台部署

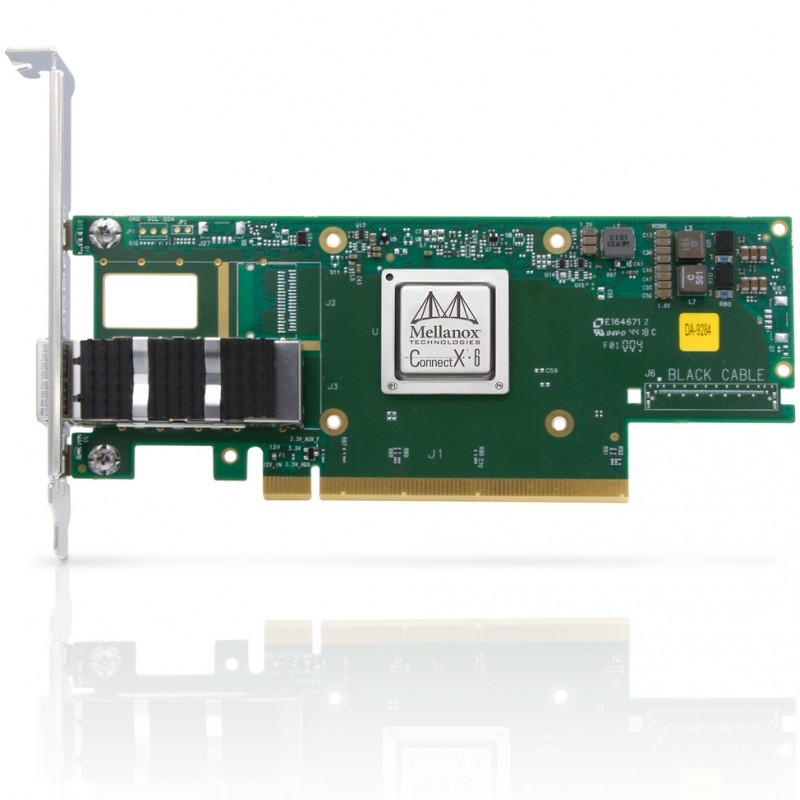

推荐型号:Mellanox ConnectX-5 EN(双端口10G SFP+)

关键配置:

# 启用SR-IOV mlxconfig -d /dev/mst/mt4115_pciconf0 set SRIOV_EN=1 NUM_OF_VFS=16 分配虚拟功能 echo "8086 10ed" > /sys/bus/pci/drivers/mlx5_core/new_id

性能表现:单虚拟机可达9.2Gbps吞吐量

2. 分布式存储网络

最佳实践:使用RoCEv2协议替代TCP/IP

# 配置无损网络 ethtool -K eth0 rx on tx on echo 1 > /sys/class/InfiniBand/mlx5_0/ports/1/flow_counters/enable

实测数据:NVMe-oF延迟降低至80μs

三、性能调优与故障排查

| 常见问题 | 诊断方法 | 解决方案 |

|---|---|---|

| 速率不达标 | ethtool -S eth0 | grep drop | 调整TCP窗口大小(-w 512K) |

| CPU占用高 | perf top -C 2 | 启用TSO/GRO硬件卸载 |

| RDMA连接失败 | ibv_devinfo -v | 检查PFC配置 |

调优案例:Kubernetes网络加速

安装Multus CNI插件

配置RDMA设备插件:

apiVersion: v1 kind: ConfigMap metadata: name: rdma-devices data: config.json: | { "configList": [{ "resourceName": "rdma/connectx5", "rootDevices": ["mlx5_0"], "deviceType": "net" }] }验证性能:iperf3测试延迟降至5μs

根据第三方测试数据,采用智能网卡的OpenStack平台可提升虚拟机迁移效率40%。建议用户:

金融交易系统选择CX-6系列(延迟<3μs)

云服务商优先考虑OCP 3.0规格网卡

每季度更新固件(MLNX_OFED 5.9+)

特别提示:在部署25G/40G网络时,需确保交换机端口与网卡速率匹配。实际案例表明,错误配置会导致性能下降达60%。对于Windows Server环境,建议使用2025年新发布的NDIS 6.85驱动以获得最佳性能。